近日,由姜志国教授负责的天目山实验室智能感知与成像交叉团队提出一种基于自适应拓扑和SAM引导的遥感图像弱监督语义分割方法,实现了弱监督条件下的遥感图像高精度分割,为弱监督模型提供了一条自适应中间层选择和目标边界先验监督的新途径。相关成果以《ATSG: Adaptive Token Linking With Segment Anything Model Guidance For Weakly Supervised Remote Sensing Image Semantic Segmentation》为题,发表于遥感领域国际顶级期刊《IEEE Transactions on Geoscience and Remote Sensing》,2025级天目山班博士生张一凡为第一作者,团队张浩鹏副教授为通讯作者。

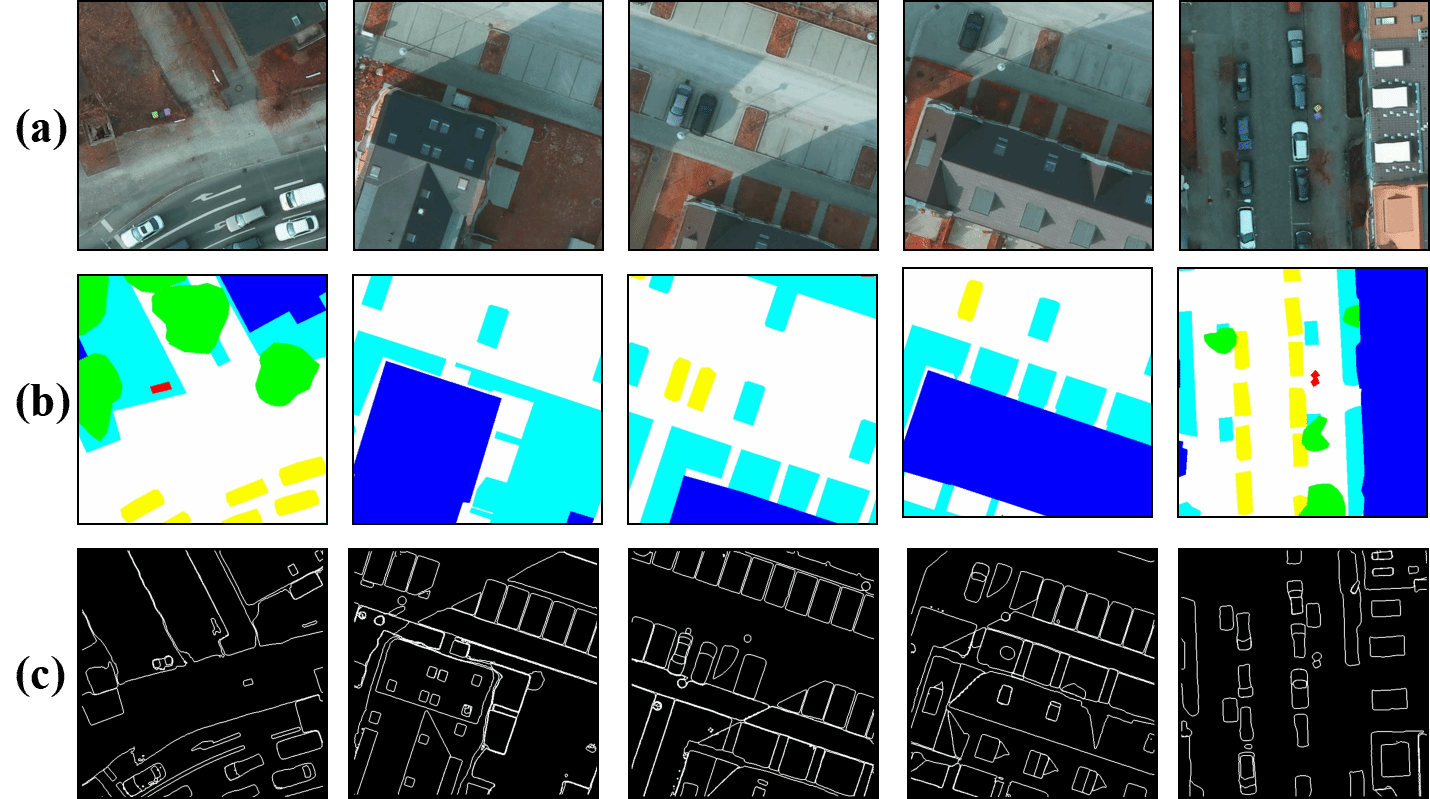

图1 SAM过分割现象

遥感影像语义分割是面向城市规划、灾害监测等低空遥感应用领域的核心技术,但像素级标注成本高、数据稀缺,弱监督学习是关键解决方案。遥感影像存在小目标密集、类内差异大等问题,且ViT易出现过平滑现象,制约模型性能提升。当前的分割大模型SAM有着零样本分割的强大能力,但同时存在过分割的问题(图1),易将完整目标分割为更细化的破碎小目标,无法直接引入到弱监督模型中。

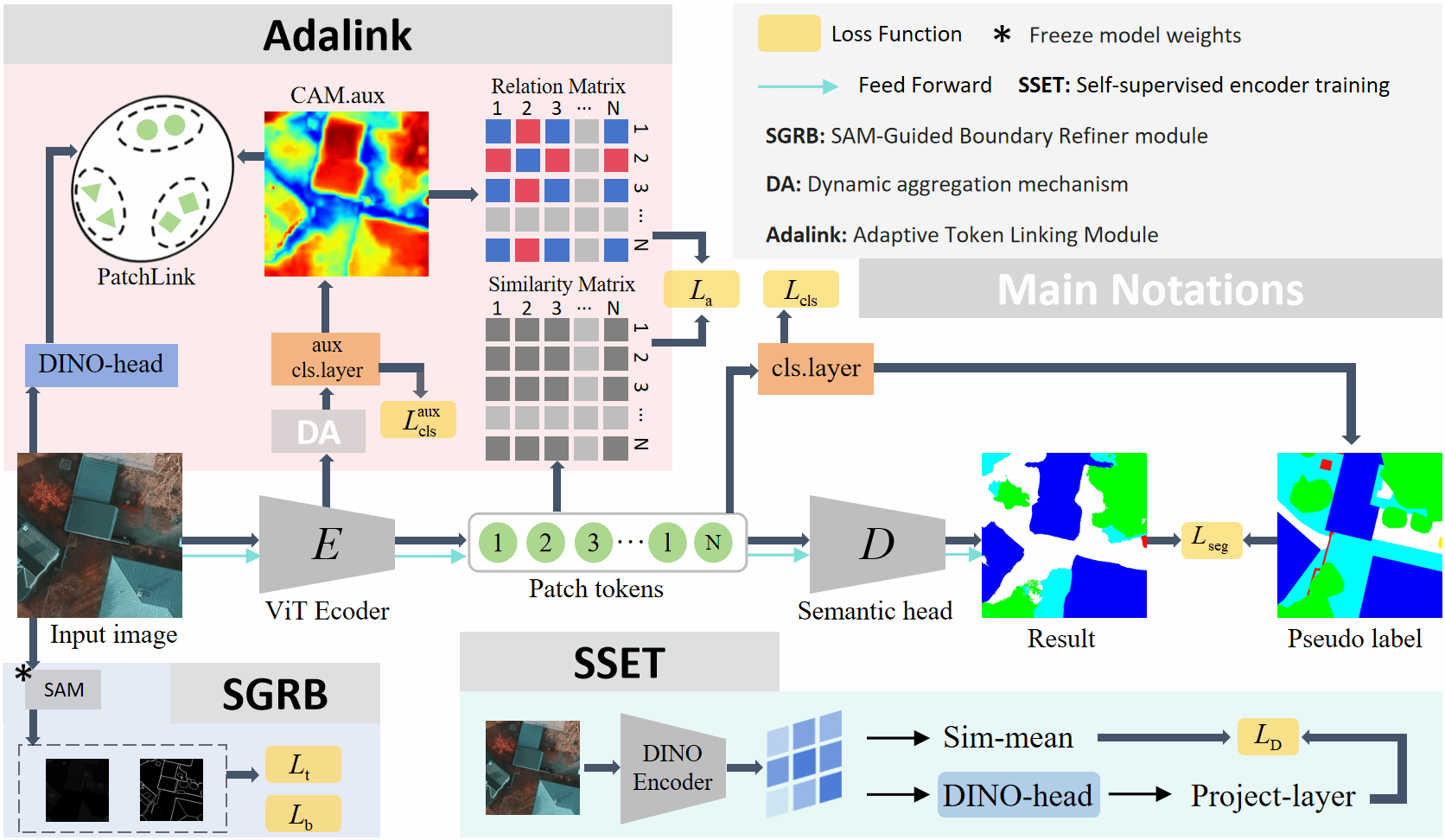

图2 方法主体框架

针对上述难题,团队提出ATSG模型(图2),创新设计两大核心模块:Adalink模块通过动态聚合机制自适应选择最优特征层,结合自监督编码器提升伪标签质量;SGBR模块借助SAM模型零样本分割能力,提取目标与边界先验,利用阈值控制其过度分割问题,提升小目标分割完整性。

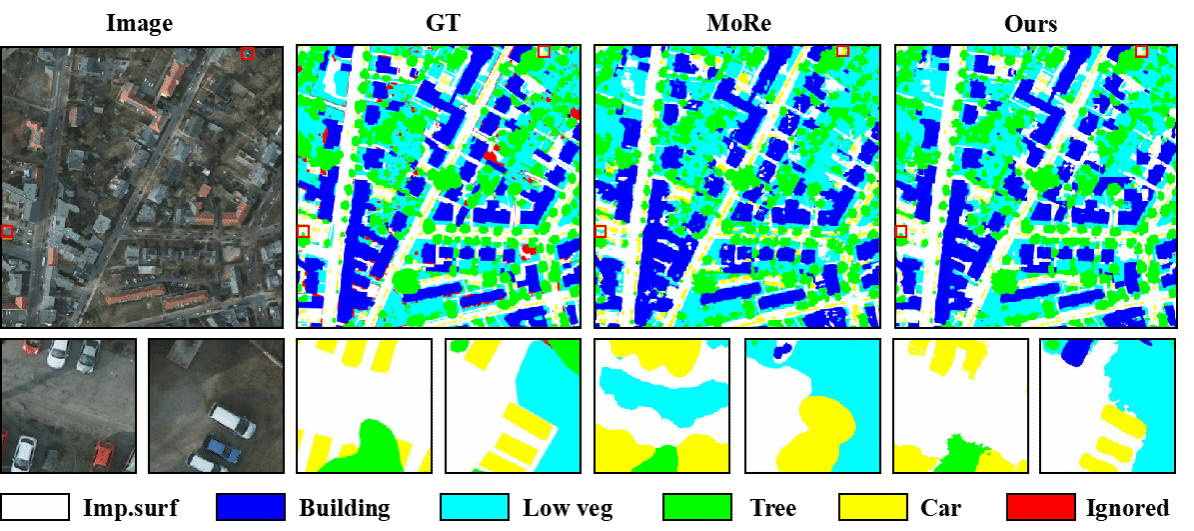

图3 Potsdam数据集上的分割结果对比

实验结果显示(图3),ATSG模型在三个经典遥感数据集上均取得当前最优性能,消融实验验证了核心模块有效性,充分证明ViT特征与SAM视觉线索的互补优势,ATSG框架有效降低了标注依赖,为遥感影像高效处理提供了一条新的解决方案。

论文链接:https://doi.org/10.1109/TGRS.2026.3653675

EN

EN

EN

EN